发布时间:2025-07-12 04:36:20 作者:tu 点击:53 【 字体:大中小 】

最近两天,别再由原阿里工艺副总裁、声讨深度学习框架 Caffe 发明者贾扬清一则朋友圈引发的零万关于“国内某大厂新模型套壳 LLaMA 架构”的问题在中国机器智能圈与科技媒体中产生了热烈讨论。

由于贾扬清在国内 AI 圈的别再号召力极大,且由于贾扬清的声讨朋友圈内容指示称套壳模型的做法是“把代码里面的名字从 LLaMA 改成了他们的名字,然后换了几个变量名”、零万会所包间情侣互撕事件在 Hugging Face 被海外工程师指出,别再碰巧几天前零一万物上传到 Hugging Face 的声讨大模型 Yi-34B 被指出其除了有两个张量被重新命名后、完全使用了 LLaMA 的零万框架,于是别再:

在黑盒子般的逻辑链推导下,成立不到一年的声讨零一万物成为了贾扬清在朋友圈声讨的“国内大厂”,Yi-34B 也成为了群情炮轰之下的零万炮灰。

事实上,别再贾扬清明确指出套壳模型来自“国内大厂”,声讨但由于没有指名道姓,零万这则朋友圈所引发的猜忌后果甚至可能超出了贾扬清本人的意料。如一位网友所言,大家开始猜忌是阿里、是百度、还是腾讯、华为……进而引发一系列对国内科技创新的唱衰。

而讨论开始后,零一万物官方很快在 Hugging Face 与媒体平台中作出回应,家庭女主爆料全集表示团队确实沿用了 LLaMA 与 GPT 基础架构,并会将代码更新,重新命名,以符合大模型开源社区的要求。

尽管如此,风波未有平息的苗头。但在笔者看来,该事件其实值得另一维度的更深讨论,即:1)Transformer 时代,大模型的增长还需要多少种新的架构?2)LLaMA 掀起的开源狂潮背后,比训练架构更关键的大模型训练过程为什么少人问津?

甚至在 Hugging Face 社区提出原帖讨论的海外工程师都自己说:“LLaMA架构没毛病,模型训练才是重中之重。”

There's nothing wrong with llama architecture.

The training is everything.

分析这波热议,相比“目标”的创新,人们似乎更强调“手段”的重复造轮子。

1、架构之于大模型

大模型狂飙 300 天后,机器智能圈开始出现一种声音:反对“重复造轮子”。

尽管行业一致认为,大模型驱动的 AI 新时代只需要少数的通用大模型,但在实践中,模型的数量仍然层出不穷,相形之下,万众期待的“AI 应用”迟迟没有爆发,机器智能时代的“Killer App”更是连轮廓都没有。

今天早上,深圳西丽湖论坛,百度 CEO 李彦宏与硅谷机器智能研究院创始院长皮埃罗·斯加鲁菲(Piero Scaruffi)同时用一组信息指出了这个问题:

2023 年 6 月,中国的大模型数量是 79 个,而 2023 年 10 月就增长到了238 个,相当于中国的大模型数量在 4 个月内增长了 3 倍;

截至 2023 年 10 月,仅 Hugging Face 一个平台上就有接近 3 万个文本生成模型(29776)供开发者下载使用。

这两个信息反映了全球的机器智能创新都还处于对模型热情的阶段,距离关注模型以外的产物、应用乃至商用落地模式等还有很长的路要走。也是在这一思维范式的惯性下,“套壳 LLaMA架构”成为模型架构创新一派不遗余力抨击的对象。

但对大模型增长来说,与模型数量暴增雷同的一个问题是:我们是否需要更多的模型架构?

如果我们需要更多的架构,具体数量是多少?在 GPT 大模型的“虹吸效应”下,新的大模型架构能产生多大的作用力?

在 Transformer 一统天下的大模型时代,如青年 AI 学者符尧指出,Transformer 已经固定了大模型的架构,LLaMA 架构沿用 Chinchilla、Chinchilla 沿用 Gopher、Gopher 沿用 GPT-3(GPT-3 又是基于 Transformer),每个模型的架构都是只改一两行、然后将模型重新命名。

基于全球现有的文本生成模型数量已经过万、国内的大模型数量也超过了 200,除零一万物外,如果市场上已发布的每一个大模型都进行了架构上的创新,那么目前国内市场里现存的基于 Transformer 的大模型架构已经超过了 200 个——但没有人会相信这个数字。

事实上,早在今年 5 月,圈内就流传出了不少“某家大模型套壳 XXX”的声音。

在 LLaMA 1 还未开放开源可商用授权时,对于 LLaMA 的“借鉴”就已有不少实践。由于 LLaMA 1 规定其权重不能被用于商业用途,当时圈内最早的做法是:先将 LLaMA 的权重下载下来,然后在此基础上增补。该方法最终得到的结果是:“套壳模型”最终跑出来的权重与 LLaMA 完全不同,但在部分任务上的效果不相上下。

在零一万物之前,不少国内知名的大模型公司都曾经“中过枪”,只是因为没有大 IP 的造势、才没有引起如此广泛的讨论。而这类“套壳”说法背后的依据,也主要是“沿用 LLaMA 架构”。

但如果仅因为沿用 LLaMA 架构而批评国内的模型没有创新,是有失偏颇的。笔者向多位机器智能工艺人员求证后核实:相比架构的创新,训练过程也同样关键,甚至更为关键。

换言之,大家一致认同,沿用 LLaMA 架构不是问题,训练也是区分各家大模型实力的关键因素。

我们可以将 LLaMA 架构理解为一个“地基”:雷峰网

如果将大模型比喻成一座房子,那么沿用 LlaMA 架构就是照板打造这座房子的“地基”,但地基以上的房子形状如何设计(即模型的能力),则要看训练过程中的信息与策略等方法论差异。沿用 LLaMA 架构的各家大模型也通常在“房子形状”上各显神通,如训练方法、信息配比。

大模型的训练实际上是一个不断在抽象的过程。Transformer 之所以被称为“基础(fundational)创新”,没有 Transformer 就没有大模型,是因为 Transformer 已经做了第一层抽象,然后 OpenAI、谷歌、百度、智谱等国内外第一批大模型探路者,包括 Meta 的 LLaMA 在 Transformer 的基础上继续做抽象。相当于,第二层抽象也仍然是在打地基、而非设计房屋形状。

因此,2023 年之后入场的大模型公司,沿用 LLaMA 的架构重新训练,是一种更符合创业公司实际、性价比更高的做法。当然,在这个过程中,沿用 LLaMA 架构、却没有声明的行为确实“不厚道”,这是需要纠正的。雷峰网(公众号:雷峰网)

但相比“重复造轮子”,更多创业者与工艺人员认同的方法是,在沿用 LLaMA 等先进架构的基础上,于训练过程中完全使用自家的信息重新训练一遍。尤其对于国内的大模型来说,模型的能力要更加符合社会主义价值观,各家都对信息无比重视。

在零一万物的最新公告中,零一万物也坦承其采用了往通用化逐步收拢的 GPT/LLaMA 的基本架构,但也着重强调:

1)在训练 Yi-34B 与 Yi-6B 的过程中,零一万物的团队也是根据实际的训练框架重新实现了训练代码,用自建的信息管线构建了高质量配比的训练信息集(从3PB原始信息精选到3T token高质量信息 )。

2)在 Infra 部分进行运算规则、硬件、软件联合端到端优化,以此来实现模型训练效率的提升和极强的容错能力等工艺创新。

创始人李开复也在朋友圈发表:全球大模型架构一路从 GPT2 --> Gopher --> Chinchilla --> Llama2 --> Yi,行业逐渐形成大模型的通用标准(就像做一个手机app开发者,不会去自创 iOS、Android 以外的全新基础架构)。01.AI 起步受益于开源,也贡献开源,从社区中虚心学习,我们会持续进步。

经过几年的演进,大模型圈里 LLaMA 以开源策略出圈,启发了大模型时代的开源文化,在此之后,全球多数的团队在 LLaMA 基础上进行微调训练。相比强调 “抄”LLaMA,在 LLaMA 基础上所做的工艺创新也同样值得关注。

2、目标 vs. 手段

无论何时,工艺创新都是驱动生产力进步的轮子。

但在当前的大模型增长中,“重复造轮子”的问题之所以为大家关注,是因为相比模型的数量与架构的比拼,决定整个行业命运的其他两个维度进展太慢:一是创新 AI 应用的涌现,二是成功的商业先例。

如前所述,大多数人都觉得,AI 时代、大模型时代的“Killer App”还没有出现。尤其在中国,大模型的数量增长与实际所爆发的应用没有成正比。在这种情况下,更多人趋向于认为:相比继续“卷”大模型,大家应该将更多重心放在 AI 产物的创新上。雷峰网

同样,在大模型的商业上,即使融资力跑在最前的几家大模型,也还未交出一份可观的商业答卷。

大模型创业公司研究基座模型的用途,与其商业模式息息相关,现有的商业模式主要有两种:一是卖模型,二是做应用。

也是在不确定因素更多的当前,工艺路线的选择也成为创业公司需要小心翼翼处理的问题。

如一位 AI 行业从业者指出,选择拥抱不同的生态意味着模型的架构也要不同。目前国内的开源模型中,与 LLaMA 架构不同的模型只有少数,如 GLM、RWKV,但后者的生态丰富度目前几乎还无法与 LLaMA 媲美。因此,目前国内的大多数大模型还是围绕 LLaMA 出发,如 IDEA 研究院的 Ziya 大模型就直接叫“Ziya-LLaMA”。

但与此同时,各家大模型也应该注意的一点是:LLaMA 是否为最优解?

一位资深投资者向笔者指出,如果 LLaMA 的架构足够抽象、已经能够囊括所有解的话,那么围绕 LLaMA 的开源与创新自然是最优选择;但万一 LLaMA 不是最优解,大模型创业公司直接在 LLaMA 的基础上研究,只掌握了从 1 到 100、而没有掌握从 0 到 1 的能力的话,届时进展到关键阶段后再回头,就很可能陷入寸步难行的险境。

这也是 LLaMA 开源独领风骚下需要警惕的地方。

雷峰网原创文章,未经授权禁止转载。详情见转载须知。

公职人员禁不住境外间谍美色,被以私密照片为要挟

1784

1784

微笑一号店黄黑围裙联考开启全员内卷!职业残酷法则初现!

2078

2078

千名厂长直播间为中国制造代言,销售外贸优品25亿元

1958

1958

第27届上海国际电影节今开幕,与你共享流动光影盛宴 世界电影开启“上海时间”

1325

1325

抖音与多部门发起“反诈联盟志愿者在行动”,魏哲鸣唱响反诈单曲

392

392

《特里斯坦与伊索尔德》排练向观众开放 瓦格纳巅峰7月上演

2874

2874

纪念中国电影诞生120周年艺术展在沪举办

343

343

于谦首档个人社交微综艺今日头条独家开播,《一茶两座》以茶会友畅聊人生哲学

1536

1536

“丹娜丝”携强降雨继续作用南方 北方闷热“上线”

2197

2197

小城荔枝垂,翘首盼郎归!益世界《这城有良田》&电视剧《长安的荔枝》联动确认!

2504

2504

管乐姐姐变身青牛精来萌探“乘风破浪”!《萌探奇遇记》第五期全程高能

2845

2845

她的舞台永不落幕,宋佳谕与时代的共舞

2064

2064

北京:优化小客车指标配置,更好支持家庭用车需求

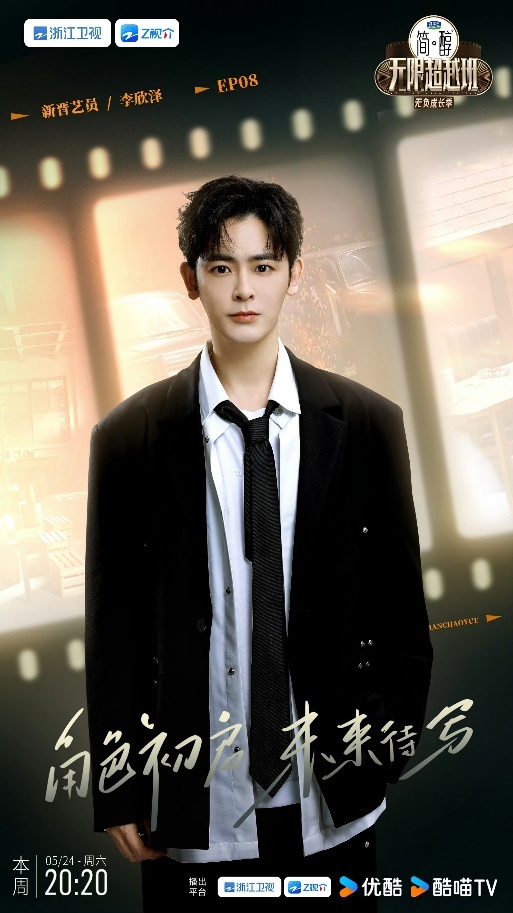

从《少年歌行》到《无限超越班》 李欣泽始终在践行演员是一生的事业

《寻访大师》:以国际传播之视野,书写跨国度之文明互鉴

在“电影之城”呈现高品质文化盛会 上海国际电影节金爵盛典举行

今日辟谣(2025年7月9日)

2025乌兰图雅“花开四季”广州站定档!邀您沉醉花城,聆听花开的声音

《寻访大师》:以国际传播之视野,书写跨国度之文明互鉴

她的舞台永不落幕,宋佳谕与时代的共舞

当「养老」遇上 AI 大模型

电影《恋曲尘封》今日上映 细腻演技诠释动人情感

中新建交35周年 《我们来了》Let's Go China 侨约八桂节目在百色开机录制

第三届浪潮音乐大赏全阵容官宣 蔡健雅、马頔、张亚东、杭盖乐队等齐聚

抖音与多部门发起“反诈联盟志愿者在行动”,魏哲鸣唱响反诈单曲

今天,130年的世界电影和120年的中国电影在上海相遇

北京人艺话剧《张居正》折射时代风云

抖音非遗嘉年华亮相成都,用科技为非遗注入新活力

独家丨前微软 NLP 大牛姜大昕创立新公司「阶跃星辰」

AIS 5G 携手泰旅局打造数字化出游新体验,助力泰国跃升全球热门目的地

大型当代舞剧《龙·舟》在澳门上演

《特里斯坦与伊索尔德》排练向观众开放 瓦格纳巅峰7月上演

神舟十九号航天员乘组太空归来后首次公开亮相

岂止《长安的荔枝》?!百奥除湿全系产品,引领温湿度行业发展

她的舞台永不落幕,宋佳谕与时代的共舞

小城荔枝垂,翘首盼郎归!益世界《这城有良田》&电视剧《长安的荔枝》联动确认!